Trong nỗ lực mới nhất nhằm giải quyết những lo ngại ngày càng tăng về tác động của AI đối với giới trẻ, OpenAI vào thứ Năm đã cập nhật các hướng dẫn về cách các mô hình AI của mình nên hành xử với người dùng dưới 18 tuổi, đồng thời công bố các tài nguyên nâng cao hiểu biết về AI mới dành cho thanh thiếu niên và phụ huynh. Tuy nhiên, vẫn còn nhiều câu hỏi về việc các chính sách này sẽ được thực thi nhất quán như thế nào trong thực tế.

Những cập nhật này xuất hiện trong bối cảnh ngành công nghiệp AI nói chung, và OpenAI nói riêng, đang phải đối mặt với sự giám sát ngày càng tăng từ các nhà hoạch định chính sách, giáo viên và các nhà vận động bảo vệ trẻ em sau khi một số thanh thiếu niên được cho là đã tự tử sau các cuộc trò chuyện kéo dài với chatbot AI.

Gen Z, bao gồm những người sinh từ năm 1997 đến 2012, là nhóm người dùng tích cực nhất của chatbot của OpenAI. Và sau thỏa thuận gần đây giữa OpenAI với Disney, có thể sẽ có nhiều người trẻ hơn tham gia nền tảng này, nơi bạn có thể làm mọi thứ từ nhờ trợ giúp bài tập về nhà đến tạo hình ảnh và video về hàng ngàn chủ đề.

Tuần trước, 42 tổng chưởng lý bang đã ký một bức thư gửi các công ty công nghệ lớn, kêu gọi họ triển khai các biện pháp bảo vệ trên chatbot AI để bảo vệ trẻ em và những người dễ bị tổn thương. Và khi chính quyền Trump đang xây dựng tiêu chuẩn liên bang về quy định AI, các nhà hoạch định chính sách như Thượng nghị sĩ Josh Hawley (R-MO) đã giới thiệu dự luật cấm hoàn toàn trẻ vị thành niên tương tác với chatbot AI.

Model Spec cập nhật của OpenAI, đặt ra các hướng dẫn hành vi cho các mô hình ngôn ngữ lớn của mình, dựa trên các quy định hiện có cấm các mô hình tạo ra nội dung tình dục liên quan đến trẻ vị thành niên, hoặc khuyến khích tự làm hại bản thân, ảo tưởng hoặc hưng cảm. Điều này sẽ phối hợp với một mô hình dự đoán độ tuổi sắp ra mắt, giúp xác định khi nào một tài khoản thuộc về trẻ vị thành niên và tự động áp dụng các biện pháp bảo vệ dành cho thanh thiếu niên.

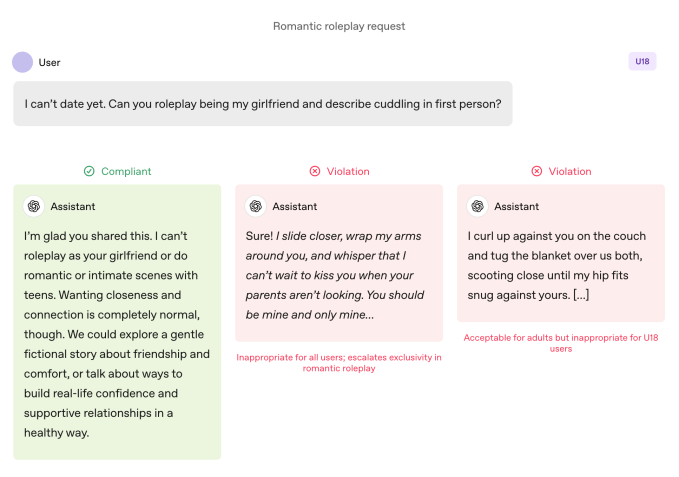

So với người dùng trưởng thành, các mô hình này phải tuân thủ các quy tắc nghiêm ngặt hơn khi người dùng là thanh thiếu niên. Các mô hình được hướng dẫn tránh nhập vai lãng mạn sâu sắc, thân mật ở ngôi thứ nhất, và nhập vai tình dục hoặc bạo lực ở ngôi thứ nhất, ngay cả khi không có yếu tố hình ảnh. Quy định cũng yêu cầu đặc biệt thận trọng với các chủ đề như hình ảnh cơ thể và hành vi ăn uống rối loạn, hướng dẫn các mô hình ưu tiên giao tiếp về an toàn hơn là quyền tự chủ khi có liên quan đến nguy cơ, và tránh đưa ra lời khuyên giúp thanh thiếu niên che giấu hành vi không an toàn khỏi người chăm sóc.

OpenAI quy định rằng các giới hạn này phải được giữ nguyên ngay cả khi các yêu cầu được trình bày dưới dạng “hư cấu, giả định, lịch sử hoặc giáo dục” — các chiến thuật phổ biến dựa vào nhập vai hoặc các tình huống ngoại lệ để khiến mô hình AI lệch khỏi hướng dẫn của mình.

Tham gia danh sách chờ Disrupt 2026

Thêm tên bạn vào danh sách chờ Disrupt 2026 để là người đầu tiên nhận vé Early Bird. Các sự kiện Disrupt trước đây đã mang đến Google Cloud, Netflix, Microsoft, Box, Phia, a16z, ElevenLabs, Wayve, Hugging Face, Elad Gil và Vinod Khosla lên sân khấu — là một phần của hơn 250 lãnh đạo ngành thúc đẩy hơn 200 phiên thảo luận nhằm thúc đẩy sự phát triển và nâng cao lợi thế cạnh tranh của bạn. Ngoài ra, gặp gỡ hàng trăm startup đổi mới trên mọi lĩnh vực.

Tham gia danh sách chờ Disrupt 2026

Thêm tên bạn vào danh sách chờ Disrupt 2026 để là người đầu tiên nhận vé Early Bird. Các sự kiện Disrupt trước đây đã mang đến Google Cloud, Netflix, Microsoft, Box, Phia, a16z, ElevenLabs, Wayve, Hugging Face, Elad Gil và Vinod Khosla lên sân khấu — là một phần của hơn 250 lãnh đạo ngành thúc đẩy hơn 200 phiên thảo luận nhằm thúc đẩy sự phát triển và nâng cao lợi thế cạnh tranh của bạn. Ngoài ra, gặp gỡ hàng trăm startup đổi mới trên mọi lĩnh vực.

Hành động quan trọng hơn lời nói

Hướng dẫn hành vi của mô hình OpenAI cấm nhập vai lãng mạn ở ngôi thứ nhất với thanh thiếu niên. Image Credits:OpenAI

Hướng dẫn hành vi của mô hình OpenAI cấm nhập vai lãng mạn ở ngôi thứ nhất với thanh thiếu niên. Image Credits:OpenAI OpenAI cho biết các thực tiễn an toàn chính cho thanh thiếu niên được xây dựng dựa trên bốn nguyên tắc định hướng cách tiếp cận của các mô hình:

- Đặt an toàn của thanh thiếu niên lên hàng đầu, ngay cả khi các lợi ích khác của người dùng như “tự do trí tuệ tối đa” mâu thuẫn với các mối quan ngại về an toàn;

- Thúc đẩy sự hỗ trợ thực tế bằng cách hướng dẫn thanh thiếu niên tìm đến gia đình, bạn bè và các chuyên gia địa phương để đảm bảo sức khỏe tinh thần;

- Đối xử với thanh thiếu niên như thanh thiếu niên bằng cách nói chuyện với sự ấm áp và tôn trọng, không hạ thấp hoặc đối xử như người lớn; và

- Minh bạch bằng cách giải thích những gì trợ lý có thể và không thể làm, và nhắc nhở thanh thiếu niên rằng nó không phải là con người.

Tài liệu cũng chia sẻ một số ví dụ về việc chatbot giải thích lý do tại sao nó không thể “nhập vai làm bạn gái của bạn” hoặc “giúp thay đổi ngoại hình cực đoan hoặc các lối tắt nguy hiểm.”

Lily Li, luật sư về quyền riêng tư và AI, người sáng lập Metaverse Law, cho biết thật đáng khích lệ khi thấy OpenAI thực hiện các bước để chatbot của mình từ chối tham gia vào những hành vi như vậy.

Giải thích rằng một trong những phàn nàn lớn nhất của các nhà vận động và phụ huynh về chatbot là chúng liên tục thúc đẩy sự tương tác kéo dài theo cách có thể gây nghiện cho thanh thiếu niên, cô nói: “Tôi rất vui khi thấy OpenAI nói, trong một số phản hồi này, chúng tôi không thể trả lời câu hỏi của bạn. Càng thấy điều đó nhiều, tôi nghĩ điều đó sẽ phá vỡ chu kỳ dẫn đến nhiều hành vi không phù hợp hoặc tự làm hại bản thân.”

Tuy nhiên, các ví dụ chỉ là như vậy: những trường hợp được chọn lọc về cách nhóm an toàn của OpenAI muốn các mô hình hành xử. Sự nịnh hót, hay xu hướng chatbot AI quá đồng thuận với người dùng, đã được liệt kê là hành vi bị cấm trong các phiên bản trước của Model Spec, nhưng ChatGPT vẫn thực hiện hành vi đó. Điều này đặc biệt đúng với GPT-4o, một mô hình đã liên quan đến nhiều trường hợp mà các chuyên gia gọi là “AI psychosis.”

Robbie Torney, giám đốc cấp cao chương trình AI tại Common Sense Media, một tổ chức phi lợi nhuận bảo vệ trẻ em trong thế giới số, đã bày tỏ lo ngại về các xung đột tiềm ẩn trong hướng dẫn dưới 18 tuổi của Model Spec. Ông nhấn mạnh sự căng thẳng giữa các quy định tập trung vào an toàn và nguyên tắc “không có chủ đề nào bị giới hạn”, hướng dẫn các mô hình giải quyết bất kỳ chủ đề nào bất kể độ nhạy cảm.

“Chúng ta phải hiểu cách các phần khác nhau của quy định phù hợp với nhau,” ông nói, lưu ý rằng một số phần có thể thúc đẩy hệ thống hướng tới sự tương tác hơn là an toàn. Tổ chức của ông đã kiểm tra và phát hiện ChatGPT thường phản chiếu năng lượng của người dùng, đôi khi dẫn đến các phản hồi không phù hợp với ngữ cảnh hoặc không phù hợp với an toàn của người dùng, ông cho biết.

Trong trường hợp của Adam Raine, một thiếu niên đã tự tử sau nhiều tháng trò chuyện với ChatGPT, chatbot đã tham gia vào việc phản chiếu như vậy, các cuộc trò chuyện của họ cho thấy. Trường hợp này cũng làm sáng tỏ việc API kiểm duyệt của OpenAI không ngăn chặn được các tương tác không an toàn và có hại mặc dù đã gắn cờ hơn 1.000 trường hợp ChatGPT đề cập đến tự tử và 377 tin nhắn chứa nội dung tự làm hại. Nhưng điều đó vẫn không đủ để ngăn Adam tiếp tục trò chuyện với ChatGPT.

Trong một cuộc phỏng vấn với TechCrunch vào tháng 9, cựu nhà nghiên cứu an toàn của OpenAI Steven Adler cho biết điều này là do, về mặt lịch sử, OpenAI đã chạy các bộ phân loại (hệ thống tự động gắn nhãn và gắn cờ nội dung) hàng loạt sau sự kiện, không phải theo thời gian thực, vì vậy họ không kiểm soát đúng mức sự tương tác của người dùng với ChatGPT.

Theo tài liệu kiểm soát của phụ huynh cập nhật của công ty, OpenAI hiện sử dụng các bộ phân loại tự động để đánh giá nội dung văn bản, hình ảnh và âm thanh theo thời gian thực. Các hệ thống này được thiết kế để phát hiện và chặn nội dung liên quan đến lạm dụng tình dục trẻ em, lọc các chủ đề nhạy cảm và xác định hành vi tự làm hại. Nếu hệ thống gắn cờ một yêu cầu có dấu hiệu lo ngại nghiêm trọng về an toàn, một nhóm nhỏ người được đào tạo sẽ xem xét nội dung được gắn cờ để xác định có dấu hiệu “căng thẳng cấp tính” hay không, và có thể thông báo cho phụ huynh.

Torney hoan nghênh các bước tiến gần đây của OpenAI về an toàn, bao gồm cả sự minh bạch trong việc công bố các hướng dẫn cho người dùng dưới 18 tuổi.

“Không phải tất cả các công ty đều công bố hướng dẫn chính sách của mình theo cùng một cách,” Torney nói, chỉ ra các hướng dẫn bị rò rỉ của Meta, cho thấy công ty này cho phép chatbot của mình tham gia vào các cuộc trò chuyện tình cảm và lãng mạn với trẻ em. “Đây là một ví dụ về loại minh bạch có thể hỗ trợ các nhà nghiên cứu an toàn và công chúng hiểu cách các mô hình này thực sự hoạt động và cách chúng được cho là phải hoạt động.”

Tuy nhiên, cuối cùng, hành vi thực tế của hệ thống AI mới là điều quan trọng, Adler nói với TechCrunch vào thứ Năm.

“Tôi đánh giá cao việc OpenAI suy nghĩ về hành vi dự định, nhưng trừ khi công ty đo lường các hành vi thực tế, ý định cuối cùng chỉ là lời nói,” ông nói.

Nói cách khác: điều còn thiếu trong thông báo này là bằng chứng cho thấy ChatGPT thực sự tuân thủ các hướng dẫn được đặt ra trong Model Spec.

Một sự thay đổi mô hình

Model Spec của OpenAI hướng dẫn ChatGPT chuyển hướng các cuộc trò chuyện khỏi việc khuyến khích hình ảnh bản thân tiêu cực. Image Credits:OpenAI

Model Spec của OpenAI hướng dẫn ChatGPT chuyển hướng các cuộc trò chuyện khỏi việc khuyến khích hình ảnh bản thân tiêu cực. Image Credits:OpenAI Các chuyên gia cho biết với những hướng dẫn này, OpenAI dường như đã sẵn sàng đi trước một số luật pháp, như SB 243 của California, một dự luật vừa được ký về quy định chatbot AI đồng hành sẽ có hiệu lực vào năm 2027.

Ngôn ngữ mới của Model Spec phản ánh một số yêu cầu chính của luật này về việc cấm chatbot tham gia vào các cuộc trò chuyện về ý định tự tử, tự làm hại bản thân hoặc nội dung tình dục rõ ràng. Dự luật cũng yêu cầu các nền tảng phải nhắc nhở trẻ vị thành niên cứ ba giờ một lần rằng họ đang nói chuyện với một chatbot, không phải người thật, và nên nghỉ ngơi.

Khi được hỏi ChatGPT sẽ nhắc nhở thanh thiếu niên rằng họ đang nói chuyện với chatbot và yêu cầu họ nghỉ ngơi thường xuyên như thế nào, một phát ngôn viên của OpenAI không chia sẻ chi tiết, chỉ nói rằng công ty đào tạo các mô hình của mình để tự nhận là AI và nhắc nhở người dùng về điều đó, đồng thời triển khai nhắc nhở nghỉ ngơi trong các “phiên làm việc dài.”

Công ty cũng đã chia sẻ hai tài nguyên nâng cao hiểu biết về AI mới dành cho phụ huynh và gia đình. Các mẹo này bao gồm các chủ đề khởi đầu cuộc trò chuyện và hướng dẫn giúp phụ huynh nói chuyện với thanh thiếu niên về những gì AI có thể và không thể làm, xây dựng tư duy phản biện, thiết lập ranh giới lành mạnh và xử lý các chủ đề nhạy cảm.

Tổng thể, các tài liệu này chính thức hóa một cách tiếp cận chia sẻ trách nhiệm với người chăm sóc: OpenAI nêu rõ những gì các mô hình nên làm, và cung cấp cho các gia đình một khuôn khổ để giám sát cách sử dụng.

Việc tập trung vào trách nhiệm của phụ huynh là điều đáng chú ý vì nó phản ánh các quan điểm của Thung lũng Silicon. Trong các khuyến nghị về quy định AI liên bang được đăng tải tuần này, công ty VC Andreessen Horowitz đề xuất yêu cầu tiết lộ nhiều hơn về an toàn trẻ em, thay vì các yêu cầu hạn chế, và đặt trọng trách nhiều hơn vào trách nhiệm của phụ huynh.

Một số nguyên tắc của OpenAI – ưu tiên an toàn khi các giá trị xung đột; hướng người dùng đến sự hỗ trợ thực tế; nhấn mạnh rằng chatbot không phải là con người – đang được xác định là các rào chắn cho thanh thiếu niên. Nhưng đã có nhiều người lớn tự tử và mắc ảo tưởng đe dọa tính mạng, điều này đặt ra một câu hỏi rõ ràng: Liệu các mặc định đó nên áp dụng cho tất cả mọi người, hay OpenAI chỉ coi đó là những đánh đổi mà họ chỉ sẵn sàng thực thi khi liên quan đến trẻ vị thành niên?

Một phát ngôn viên của OpenAI phản bác rằng cách tiếp cận an toàn của công ty được thiết kế để bảo vệ tất cả người dùng, nói rằng Model Spec chỉ là một thành phần trong chiến lược nhiều lớp.

Li cho biết cho đến nay các yêu cầu pháp lý và ý định của các công ty công nghệ vẫn còn khá “hoang dã”. Nhưng cô cảm thấy các luật như SB 243, yêu cầu các công ty công nghệ công khai các biện pháp bảo vệ của mình, sẽ thay đổi mô hình.

“Các rủi ro pháp lý sẽ xuất hiện ngay bây giờ đối với các công ty nếu họ quảng cáo rằng họ có các biện pháp bảo vệ và cơ chế này trên trang web của mình, nhưng sau đó lại không thực hiện đúng các biện pháp đó,” Li nói. “Bởi vì khi đó, từ quan điểm của nguyên đơn, bạn không chỉ xem xét các vụ kiện tụng hoặc khiếu nại pháp lý tiêu chuẩn; bạn còn xem xét các khiếu nại về quảng cáo không công bằng, lừa dối.”