LazAI Mainnet ist live, wir haben mit Metis über diesen Schritt gesprochen

Die „eigenen Kinder“ von L2 sind schon immer Projekte gewesen, die man nicht verpassen darf.

Verfasst von: Eric, Foresight News

Am Abend des 22. Dezember (Ostasiatische Zeitzone) gab LazAI, die von Metis inkubierte AI-Daten- und Anwendungsschicht, den offiziellen Start des Alpha-Mainnets bekannt. Das letzte Mal, dass Metis bei mir einen bleibenden Eindruck hinterließ, war, als sie als Erste einen dezentralisierten Sequencer einführten. Während sich in den letzten Jahren viele L2-Projekte auf den Handel konzentrieren, warum hält Metis so entschlossen an AI fest?

Mit dieser Frage haben wir mit Metis gesprochen.

Fokus auf „Daten“ – Metis’ alternativer Weg

Das Metis-Team erklärte mir, dass die Einführung von LazAI keine spontane Reaktion auf den AI-Hype war. Bereits zu Beginn dieses Jahres hatte Metis die strategische Ausrichtung auf AI festgelegt, und LazAI ist das Flaggschiffprodukt, das nach fast einem Jahr intensiver Entwicklung auf den Markt gebracht wurde. LazAI ist keine reine AI-Anwendung oder ein einfaches AI-Produkt mit eigenem Token, sondern ein Netzwerk, das dem Training und der Anwendung von AI-Modellen dient.

Eine „Web3+AI“-Anwendung zu entwickeln, ist möglicherweise keine gute Wahl. Der Entwicklungsstand von AI ist derzeit noch nicht so weit, dass sich eine Integration von Web3 auf Anwendungsebene lohnen würde, oder zumindest ist die Richtung der Anwendungen noch nicht klar definiert. Der Erfolg von Stablecoins und DeFi liegt darin begründet, dass in vielen Ländern oder Regionen die finanzielle Infrastruktur unzureichend ist und so Marktlücken entstehen. Bei AI-Anwendungen hingegen glaube ich, dass Web3 kurzfristig keinen großen Vorteil haben wird.

Auf nicht-anwendungsbezogener Ebene sieht es jedoch ganz anders aus. Rückblickend auf die letzten ein bis zwei Jahre haben Cloud-Service-Anbieter wie Alibaba Cloud und AWS mehr oder weniger L2 oder auch Alt L1 Tools und Produkte wie Sui integriert. Dadurch können Cloud-Service-Anbieter vielfältigere Optionen anbieten, und Web3-Tools sind oft die kosteneffizientere Wahl.

Aus meiner Sicht ist es eine richtige Entscheidung von Metis, die eigenen Vorteile von L2 in Bezug auf Verifizierungskapazität und -geschwindigkeit zu nutzen, um LazAI zu lancieren. Darüber hinaus ist LazAI nicht einfach ein Überstülpen des Web3-Konzepts, sondern ein originäres, sowohl technisch als auch marktseitig optimal angepasstes System.

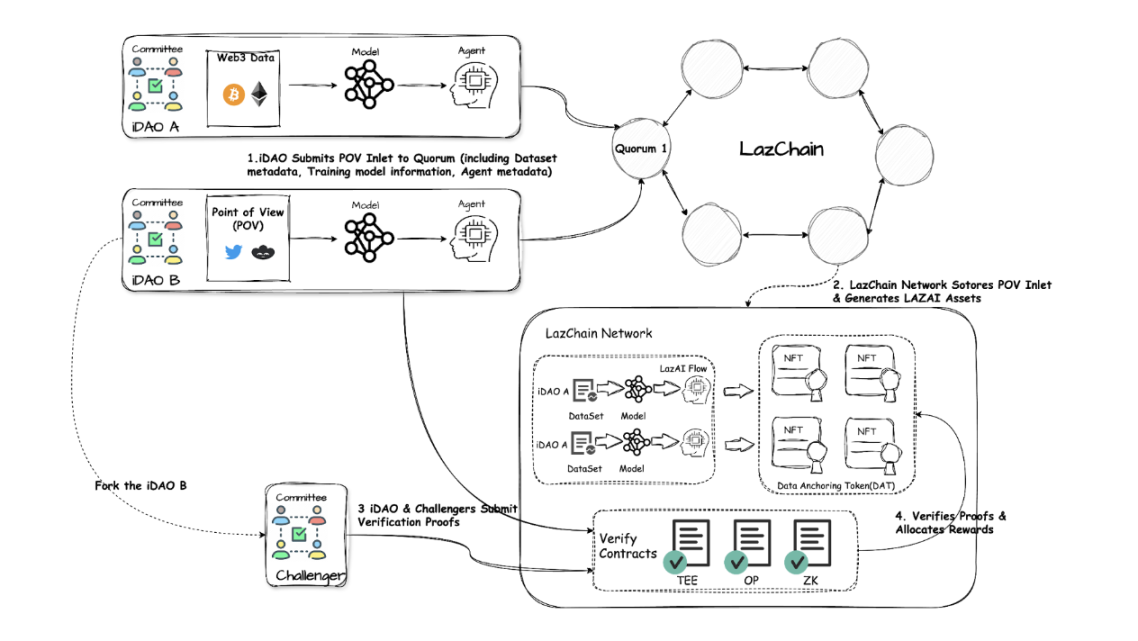

Hier zunächst eine Grafik: Das größte Merkmal von LazAI ist, dass im Design eine vollständige Lösung von Daten über Training bis hin zur Anwendung berücksichtigt wurde. Der gesamte Lebenszyklus von AI – vom Training über die Nutzung bis hin zu AI-basierten Anwendungen – kann auf LazAI abgebildet werden.

Um LazAI zu erklären, müssen zunächst drei Kernkomponenten erläutert werden: iDAO, DATs und das verifizierbare Berechnungs-Framework.

iDAO ist die kleinste Einheit im Netzwerk und zugleich ein Konsensknoten. Es kann jede Rolle im AI-Lebenszyklus einnehmen: Fachleute, die Daten bereitstellen, AI-Modelle, die mit diesen Daten trainieren, Anbieter von Rechenleistung, Teams, die AI-basierte Anwendungen entwickeln usw. LazAI zerlegt die verschiedenen Akteure im AI-Ökosystem und bietet so eine modulare und kombinierbare Struktur für AI.

DATs (Data Anchoring Tokens) sind ein von LazAI entwickelter halb-fungibler Token-Standard und die Kerninnovation von LazAI. DAT kodiert drei Schlüsselfunktionen: das „Eigentumszertifikat“, das die Herkunft und den Autor der Daten nachweist; das „Nutzungsrecht“, das z. B. die Anzahl der Inferenzaufrufe definiert; und die „Wertbeteiligung“, durch die Inhaber anteilig automatisch Einnahmen erhalten. DAT ermöglicht es Datenlieferanten und AI-Entwicklern, ihre Beiträge zu monetarisieren und auch in Zukunft kontinuierlich Einnahmen aus der Nutzung durch die Nutzer zu erzielen.

Das verifizierbare Berechnungs-Framework dient dazu, das „Blackbox“-Problem von AI-Berechnungen zu lösen und die Nachvollziehbarkeit von Daten- und Modellaufrufen zu gewährleisten. LazAI verwendet TEEs (Trusted Execution Environments), ZKPs (Zero-Knowledge Proofs) und OPs (Optimistic Proofs), um das Vertrauen in Off-Chain-AI-Ausführungen zu minimieren. TEE bietet vertrauliche Ausführung, ZKPs verifizieren die Ausgabe ohne Daten offenzulegen, OPs optimieren die Geschwindigkeit durch Annahme der Gültigkeit. Dieses hybride Nachweissystem ähnelt ZK Rollups, ist aber speziell für AI angepasst und balanciert Privatsphäre, Effizienz und Verifizierbarkeit.

Daraus ergibt sich folgender Gesamtprozess im LazAI-Netzwerk: Nutzer verschlüsseln Daten und reichen sie bei iDAO ein, iDAO bündelt sie zu einem LazAI Flow und sendet sie über VSC an das Quorum. Das Quorum verifiziert mit TEE/ZKP und verankert den Hash auf LazChain. Nach der On-Chain-Verifizierung können DATs geprägt werden, Metadaten und Rechte werden aufgezeichnet, Nutzer transferieren DATs zur Inanspruchnahme von Diensten, Off-Chain-TEE führt die Berechnung aus, das Ergebnis wird durch ZKP/OP verifiziert.

In diesem Prozess kann VSC (Verifiable Service Coordinator) als Expertengremium verstanden werden, das die Authentizität von Fachdaten bestätigt, während das Quorum den Konsensmechanismus von LazChain darstellt. iDAO fungiert als Konsensknoten und gewährleistet neben seinen eigenen Aufgaben auch den Betrieb des Konsenses.

Alpha-Mainnet-Launch – Was können wir tun?

LazAI wurde entwickelt, um das Problem des Zugangs zu lernfähigen Daten im AI-Bereich zu lösen. Die meisten Web3+AI-Projekte, die wir derzeit sehen – abgesehen von x402 – umfassen Rechennetzwerke, AI Launchpads und andere anreizbasierte Netzwerke sowie jüngst entstandene Projekte, die ebenfalls auf die Bereitstellung lernfähiger Daten abzielen. Aus meiner Sicht adressieren die ersten beiden Kategorien keine echten Bedürfnisse, sondern nutzen Web3 lediglich als besseren Träger für AI, während die letzteren zu einseitig sind.

LazAI, das gezielt für ein konkretes Problem entwickelt wurde, hat einen originären Mechanismus geschaffen, der es Beitragenden ermöglicht, kontinuierlich zu profitieren – und das fest in den Code geschrieben, statt jedes Mal ad hoc ergänzt zu werden, um die Interessen der Teilnehmer zu sichern.

Vom Team habe ich erfahren, dass das Alpha-Mainnet von LazAI zunächst keinen Token einführen wird. Für Fachleute, die Beiträge leisten können, sowie für Entwickler von AI-Modellen und -Produkten ist dies eine seltene Gelegenheit zur Selbstdarstellung und zur Monetarisierung ihrer Fähigkeiten durch Airdrops. Darüber hinaus wird LazAI für das Alpha-Mainnet ein Entwickler-Incentive-Programm mit einem Gesamtpool von 10.000 METIS auflegen, das von frühen Prototypen bis hin zu ausgereiften Anwendungen alle Phasen abdeckt und mehrstufige Ökosystemförderungen wie kanalübergreifende Promotion und Nutzerwachstumsfonds bietet.

Bereits vor dem Mainnet-Launch hat LazAI im Testnet beachtliche Erfolge erzielt. Laut Teamangaben zählt das Testnet fast 140.000 aktive Nutzer, und der von der offiziellen Mannschaft eingeführte evolvierbare AI-Begleiter Lazbubu erfreut sich bei fast 15.000 Nutzern großer Beliebtheit.

Die Erfolge im Testnet gehen noch weiter: Das Projekt ROVR Network, das Alltagsfahrzeuge in intelligente 3D-Mapper der physischen Welt verwandelt, nutzt die Lösung von LazAI.

ROVR erstellt mit seinen Geräten kontinuierlich Karten der Umgebung und generiert umfangreiche georäumliche Datensätze, die in das LazAI-Ökosystem eingespeist werden. In diesem Fall ist ROVR ein „iDAO“, dessen hochgeladene Daten als DAT gemintet werden. LazAI verfügt somit über eine hochpräzise DePIN- und RWA-Datenbank, die beispielsweise von AI-gestützten autonomen Fahrwerkzeugen zur Selbstoptimierung genutzt werden kann.

Das Team teilte mir mit, dass die Teamkultur von LazAI sehr entwicklerfreundlich ist, was sich auch in den Anreizen für Entwickler beim Mainnet-Launch widerspiegelt. Diese Wertschätzung für Entwickler hat Metis auch die Aufmerksamkeit von AI-Forschern eingebracht. Im Juni dieses Jahres trat Dr. Zehua Wang, Kernmitglied des Blockchain Research Center der University of British Columbia (UBC) und außerordentlicher Professor für Elektrotechnik und Computertechnik, als technischer Berater LazAI bei. Dr. Wang forscht seit langem im Bereich der dezentralen Multi-Agenten-Systeme und Sicherheit, mit Schwerpunkt auf der Integration von AI und Blockchain-Technologie, insbesondere im Bereich vertrauenswürdiger Edge-AI, Blockchain- und Smart-Contract-Sicherheit sowie Zero-Knowledge-Proofs.

Wie eingangs erwähnt, war Metis das erste L2, das einen dezentralisierten Sequencer in die Praxis umsetzte – ein gutes Beispiel für den Innovationsdrang des Teams. Diese technische Beharrlichkeit und die Fokussierung auf Entwickler bilden das solide Fundament für eine langfristige Entwicklung.

Warum AI wählen?

Diese Frage mag etwas naiv erscheinen. AI als heißes Thema zu wählen, scheint eine Selbstverständlichkeit zu sein, aber die Realität ist vielleicht nicht so einfach.

Generische Ethereum-L2 stoßen auf immer größere Herausforderungen. Viele Projekte entscheiden sich für eigene L1 oder entwickeln auf Basis ausgereifter Rollups eigene Application Chains, um maßgeschneiderte Performance zu erreichen. Das zwingt L2-Projekte dazu, sich neu zu positionieren und neue Richtungen zu finden, die auf ihren eigenen Stärken basieren.

Vor Kurzem sorgte ByteDance mit einem Smartphone mit integriertem Doubao für Aufsehen. Der Clou: Dank AI müssen Nutzer nicht mehr mit mehreren Apps interagieren, sondern teilen der AI einfach ihre Bedürfnisse mit, und die AI ruft die entsprechenden Apps auf, um die Wünsche der Nutzer zu erfüllen. Das verändert die Logik des „Traffic Capturing“ im Internet grundlegend – künftig könnten AI-Systeme die neuen Zugangspunkte für Nutzerströme werden.

Dieses Beispiel soll zeigen: Auch wenn viele L2-Projekte auf Handel, Prediction Markets oder RWA-Tokenisierung setzen, wird oft übersehen, dass in Zukunft nicht mehr unbedingt Menschen diese Anwendungen bedienen, sondern AI, die menschliche Anweisungen erhält. Wer den Zugang zu AI verpasst, wird mit seinen Application Chains nur noch für AI arbeiten – Metis hat dieses Problem schon vor einem Jahr erkannt.

Wie bereits erwähnt, verfolgt Metis seit Anfang des Jahres eine AI-zentrierte Strategie. Im März stellte Metis auf der ETHDenver die Dual-Chain-Strategie vor: Neben Metis selbst gibt es Hyperion, ein speziell für AI-Anwendungen optimiertes, hochperformantes L2 mit paralleler Ausführung und sofortigem Feedback. Hyperion ist eng mit dem Metis SDK integriert, unterstützt den modularen Aufbau von Application Chains und ist auf Hochfrequenzhandel und Echtzeit-AI-Anwendungen ausgerichtet.

LazAI ist das „Flaggschiffprodukt“ dieser Strategie, und alle bisherigen Maßnahmen zeigen nun ihren wahren Wert. Alle L2, auch Metis, wissen, dass ihr Effizienzvorteil gegenüber dem Ethereum-Mainnet langsam schwindet. Deshalb braucht es ein starkes Produkt, das mindestens in einem Bereich führend ist, um eine stabile Nutzung und ein funktionierendes Ökosystem zu gewährleisten. AI-Infrastruktur ist eine „schwierige, aber richtige Sache“.

Die Optimierung von AI-Datenannotation mit Web3-Lösungen ist erst in den letzten Monaten aufgekommen, und Metis gehört zu den ersten, die diesen Schritt wagen. Die Lösung von Metis ist ein typisches Web3-Native-Konzept und geht weit über die bloße On-Chain-Bestätigung und Token-Ausgabe hinaus.

Für Metis gehen die Erweiterung des On-Chain-Ökosystems und die Positionierung der Chain als Settlement Layer Hand in Hand. Ich bin überzeugt, dass der Tokenpreis in Zukunft immer stärker mit dem realen Wert verknüpft sein wird – je mehr das Netzwerk genutzt wird und je größer die echte Nachfrage nach Gas-Token ist, desto wertvoller werden Token und Netzwerk. Der Vorstoß in den AI-Bereich stärkt auch den Wert von METIS selbst. Sollte meine Prognose eintreffen, werden immer mehr nicht-AI-Application Chains auf L2-Stacks entstehen, was METIS zusätzliche Wertunterstützung bietet.

Blockchain-basierte Produkte durchdringen bereits alle Bereiche der Internetanwendungen, und im AI-Bereich ist dies besonders ausgeprägt. Ich bin weiterhin der Meinung, dass reine „On-Chain-Modelle“ oder „AI Launchpads“ keine lange Lebensdauer haben werden, aber Produkte wie LazAI, die den gesamten AI-Lebenszyklus bedienen, sind anders. Für Entwickler und Nutzer sind Produkte, die im Zentrum der Ökostrategie stehen, immer einen Blick und eine Teilnahme wert.

Haftungsausschluss: Der Inhalt dieses Artikels gibt ausschließlich die Meinung des Autors wieder und repräsentiert nicht die Plattform in irgendeiner Form. Dieser Artikel ist nicht dazu gedacht, als Referenz für Investitionsentscheidungen zu dienen.

Das könnte Ihnen auch gefallen

MicroStrategy unter Druck: Fallende Bitcoin-Preise und Index-Ausschluss belasten die Aktie

Bitcoin findet strukturelle Unterstützung, da institutionelle Käufe das $80.000-Niveau stabilisieren

Warum sich der Ausblick für Ethereum im Jahr 2026 nach einem ETH-Abfluss von 555 Mio. USD abschwächt

Experten sagen Herausforderungen für den lang erwarteten Altcoin-Bullenmarkt voraus